Aprende a Vivir Sin Ello: El Impacto de la Legislación en la IA

Serie de blogs "Future Insights 2025", post #2

0 minutos de lectura

Nota de Lionel: El Director de Cumplimiento Global, Michael Leach, examina el impacto que tendrán las próximas regulaciones sobre IA en la industria en esta segunda publicación de nuestra serie "Future Insights 2025". Si te lo perdiste, revisa el primer post sobre AISPM.

###

Las empresas están corriendo hacia una meta en la que sus stacks tecnológicos y los servicios que ofrecen están inconfundiblemente entrelazados con la inteligencia artificial.

Mientras aún hay escepticismo sobre productos como los palos de golf con IA la IA ha pasado rápidamente de ser un chatbot básico a convertirse en la tecnología subyacente de algunos de los servicios de software más influyentes en el mercado actual.

Al mismo tiempo, legisladores y reguladores de todo el mundo están afinando sus directrices para un enfoque más reflexivo y cauteloso en la incorporación de la IA. Para que las empresas se mantengan a la vanguardia, deberán considerar cómo su software impulsado por IA puede funcionar sin IA.

La Legislación Sigue a la Innovación

ChatGPT abrió la Caja de Pandora. Poco después de su lanzamiento a finales de 2022, decenas de miles de empresas de IA inundaron el mercado, prometiendo hacerlo todo más rápido y mejor.

Con la avalancha de OPI y lanzamientos de productos, quizás te perdiste lo que estaba ocurriendo tras bambalinas. Los legisladores rápidamente se pusieron a trabajar en establecer directrices y barreras para la tecnología más transformadora desde internet.

Varios países introdujeron sus propias versiones de frameworks de IA globales. Estos proporcionan orientación práctica para empresas del sector privado en un intento de abordar cuestiones clave de ética y gobernanza al diseñar y desplegar soluciones de IA. Estos marcos enfatizan la transparencia, la equidad y la responsabilidad. Ejemplos de marcos de IA incluyen:

Marco de Ética para la IA de Australia

Marco de Gobernanza de IA Modelo de Singapur

Estrategia Nacional de IA de India

Estrategia Nacional de IA de Corea del Sur

Directrices Éticas de IA de Emiratos Árabes Unidos

Algunos de estos marcos llegaron junto con leyes globales sobre IA diseñadas para avanzar a nivel nacional:

Ley de IA de la UE: Se enfoca en la regulación de sistemas de IA basada en riesgos, categorizándolos en riesgo inaceptable, alto, bajo o mínimo.

Orden Ejecutiva sobre IA en EE.UU.: Enfatiza la transparencia, la seguridad y la privacidad en el desarrollo y la implementación de la IA, y pide nuevos estándares y mejores prácticas en diversos sectores.

Directiva sobre Toma de Decisiones Automatizada de Canadá: Garantiza que los sistemas automatizados de toma de decisiones se utilicen de manera transparente, responsable y coherente con los derechos humanos. Requiere evaluaciones de impacto y monitoreo continuo.

Muchas de estas políticas se basan en leyes de protección de datos y privacidad ya existentes, algunas de las cuales ya tienen en cuenta cómo interactúa la IA con los datos. Estas incluyen GDPR, CCPA, LGPD, LFPDPPP, PIPA, APPI y la Ley de Privacidad de Australia de 1988. Comprender para qué sirven estas regulaciones, hasta dónde llegan (o no llegan) y a quién se aplican es un primer paso, a menudo pasado por alto, para una verdadera adopción de la IA.

Mucho Ruido y Algo Más

La legislación está impulsando a las empresas a ser más reflexivas sobre la IA y su impacto en los usuarios finales. Las empresas tienen la responsabilidad de garantizar que los datos estén en buenas manos, como ocurre con cualquier otra aplicación, y los usuarios deben mantener el control sobre qué datos se alimentan a la IA, en caso de que quieran eliminarlos.

Muchas empresas colocan una interfaz de usuario en la IA y esperan que voilà: la financiación de la Serie A esté a la vuelta de la esquina. Pero para muchas de estas startups, todo el back end del producto es de código abierto, y la IA se entrena con esos datos.

Con la legislación sobre IA en mente, las organizaciones deben mantener un control completo sobre los datos. En algunos casos, eso significa asegurarse de que la IA sea plug-and-play en lugar de una solución única para todos. Considere lo siguiente:

- Los datos son un camino de una sola vía. La IA debe funcionar como un modelo cerrado a nivel empresarial.

- La IA varía según la función. Evalúe las inversiones en IA en función de quién es usted, ya sea soporte al cliente, desarrollo de software o marketing, por ejemplo. La criticidad o sensibilidad de los datos que comparte con esa IA debe reflejar las medidas de seguridad que tiene implementadas.

- La IA debe ser transparente. Documente todo y asegúrese de que las personas comprendan cómo se utiliza la IA dentro de un producto. No comparta propiedad intelectual, pero explique cómo los datos se mueven de la entrada a la salida. Aquí hay un ejemplo de cómo Forcepoint hace esto con AI Mesh.

Mantén el 'Botón de Apagado' a la Vista

Lo más importante es que las empresas deben ser cada vez más conscientes de cómo se integra la IA en la pila de servicios. Esto se debe a que, de manera individual, las organizaciones deben permitir que los usuarios soliciten que la IA se desactive.

Considere esto: si ha pasado el último año desarrollando un chatbot de IA completamente nuevo y una legislación permite a los usuarios optar por no usarlo, ¿cómo manejará esta solicitud? Deben tomarse en cuenta los flujos de trabajo existentes y cómo las regulaciones pueden impactarlos.

Como ejemplo, Forcepoint informa a los usuarios, tanto en la ventana de aviso como durante la salida generada, que están interactuando con IA antes de utilizar las capacidades del chatbot de IA proporcionadas por Forcepoint.

Forcepoint también proporciona una lista de nuestros subprocesadores de datos que utilizamos para apoyar nuestros productos y operaciones. Es por eso que nuestras herramientas y servicios de IA están marcados con (*), a través de nuestra Lista de Subprocesadores de Forcepoint en nuestro sitio web.

Al chatear, das tu consentimiento para el procesamiento de tus datos y para que el chat se almacene de acuerdo con la Política de Privacidad de Forcepoint. Ten en cuenta que este chatbot utiliza Inteligencia Artificial Generativa para procesar y responder a preguntas. Las respuestas del chatbot pueden contener errores, por lo que se recomienda verificar la exactitud de la salida

Este uso binario de la IA se convertirá en el estándar en 2025 y más allá, a medida que las empresas sigan lidiando con cómo ofrecer servicios de software impulsados por IA, mientras siguen proporcionando la opción para que los usuarios se excluyan de la parte de IA de esos servicios.

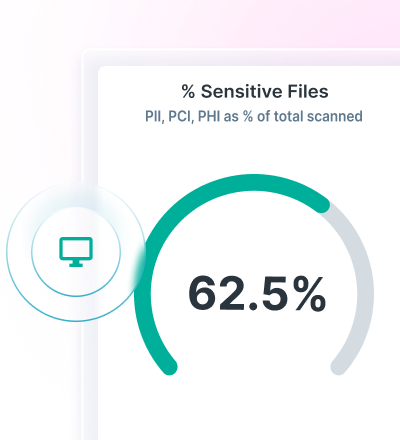

Además de la opción de exclusión, las organizaciones también deben tener la capacidad de identificar a las personas específicas que interactúan con la IA y los datos personales que comparten en ella. Data Security Posture Management (DSPM) ayuda en este aspecto al identificar y clasificar los datos que tienes, de modo que puedas monitorear las interacciones con plataformas como ChatGPT Enterprise para garantizar que la actividad de los usuarios finales no resulte en incumplimiento.

Los usuarios están ansiosos por aprovechar la IA, y las empresas tienen razón al dirigirse hacia el punto de la innovación. Sin embargo, los proveedores de software deben tener en cuenta la legislación en el diseño de sus servicios, y cuanto antes, mejor.

Michael Leach

Leer más artículos de Michael LeachComo Director de Cumplimiento Global, Michael proporciona la orientación legal necesaria y los requisitos para las operaciones de Forcepoint para garantizar que cumplamos con las leyes y regulaciones gubernamentales aplicables, incluyendo ciberseguridad, protección de datos y privacidad, seguridad de la información, cumplimiento comercial de importación y exportación y leyes anticorrupción.

- Future Insights 2025

En este post

Future Insights 2025Read the Series

Future Insights 2025Read the Series

X-Labs

Reciba información, novedades y análisis directamente en su bandeja de entrada.

Al Grano

Ciberseguridad

Un podcast que cubre las últimas tendencias y temas en el mundo de la ciberseguridad

Escuchar Ahora